AUTOR

Miquel Àngel Fuentes Arjona es profesor de inglés en un centro público de educación secundaria y FP. También ha ejercido como formador en competencia digital docente en diversos cursos del Departamento de Educación de Cataluña. En los últimos cursos, ha estado implicado en la creación de materiales educativos y en las formaciones del proyecto ‘Inteligencia artificial en educación’ de XTEC.

X @miquelangel_f BlueSky @miquelangelfuentes.bsky.social

Abstract

La introducción de la inteligencia artificial generativa (IAG) en el ámbito educativo ofrece oportunidades valiosas para el aprendizaje personalizado, pero también plantea desafíos éticos, sociales y culturales. Uno de los más relevantes es su impacto en la perpetuación de desigualdades de género y en la proliferación de nuevas formas de violencia digital, como los deepfakes y el contenido manipulado sin consentimiento. Varios casos en España demuestran que menores pueden utilizar estas herramientas para crear imágenes falsas de desnudos, lo cual subraya la urgencia para abordar la competencia digital desde la perspectiva de género.

Integrar la coeducación y la ciudadanía digital en la educación sobre IAG es necesario para evitar que los avances tecnológicos reproduzcan dinámicas de discriminación y violencia. La perspectiva de género permite identificar y desafiar desigualdades, así como fomentar el respeto, la empatía y el consentimiento en entornos digitales. Es por ello que los docentes tenemos la responsabilidad de proporcionar un marco ético y crítico en el uso de estas tecnologías, y garantizar que el alumnado desarrolle habilidades digitales alineadas con valores de igualdad y justicia social.

Asimismo, es crucial que las familias, centros educativos y autoridades trabajen de manera conjunta para establecer protocolos de prevención y actuación ante situaciones de abuso digital. La formación del profesorado en perspectiva de género, el apoyo a las víctimas y el desarrollo de políticas educativas inclusivas son estrategias imprescindibles para afrontar estos desafíos.

Por último, abordar la interseccionalidad entre los usos éticos de la IA, la ciudadanía digital y la igualdad de género no solo puede prevenir los malos usos de la IAG, sino que también puede promover una cultura digital más consciente y equitativa. De este modo, la educación puede convertirse en un motor de cambio hacia un futuro en el cual la tecnología sirva para el progreso social y no perpetúe las desigualdades.

Palabras clave

inteligencia artificial generativa (IAG), perspectiva de género, coeducación, deepfakes

Por un aprendizaje personalizado con perspectiva de género

La integración de la inteligencia artificial generativa (IAG) en el ámbito educativo suele asociarse al aprendizaje personalizado, entendido como la adaptación de contenidos, ritmos y estrategias pedagógicas a las necesidades, intereses y características individuales del alumnado (UNESCO, 2017, p. 5). La relación entre la perspectiva de género, la IAG y el aprendizaje personalizado se sustenta en la aspiración de formar individuos competentes y autónomos, a la vez que comprometidos con la igualdad, la justicia y la dignidad humana. Situar al alumnado en el centro del proceso educativo implica reconocer sus intereses, pasiones y aspiraciones (Bray & McClaskey, 2017, p. 7). Pero para que este proceso sea realmente inclusivo es necesario que esta personalización se produzca dentro de un marco que defienda la convivencia y el respeto mutuo. Como docentes, debemos garantizar que ningún avance tecnológico, por útil que sea, se convierta en vehículo para la reproducción de desigualdades o violencias.

Incluso antes del boom de la IAG, con la llegada de ChatGPT en 2022, podemos encontrar literatura que aborda los problemas de perspectiva de género en la IA. Scheuerman, Paul & Brubaker (2019) advierten de sesgos en la tecnología de reconocimiento de rostros contra personas trans, e instan a implementar políticas sensibles al género y a crear conjuntos de datos inclusivos para reducir sesgos. Cernadas & Calvo-Iglesias (2020) también mencionan los sesgos en los conjuntos de datos en sistemas de visión artificial, y abogan por políticas que requieran la integración de la perspectiva de género en la educación sobre IA.

La irrupción de la IAG en el ámbito educativo plantea importantes retos éticos, legales, sociales y culturales. Lejos de ser una cuestión meramente técnica, el desarrollo y aplicación de modelos capaces de generar imágenes, textos y otros contenidos a partir de datos ha abierto nuevas posibilidades, pero también ha expuesto una serie de problemáticas emergentes que demandan una respuesta educativa integral. Entre estas preocupaciones destacan los denominados deepfakes: contenidos audiovisuales creados con IAG que simulan situaciones y personas de forma tan realista que resulta difícil distinguirlos de la realidad. Este fenómeno, hasta hace poco circunscrito a figuras públicas con un amplio repositorio de datos, se ha extendido a entornos más próximos y está afectando a menores de edad y entornos escolares.

Ante este nuevo escenario, los docentes necesitamos un enfoque educativo holístico que integre perspectiva de género, ciudadanía digital y usos responsables de las tecnologías. Es aquí donde entra en juego la coeducación (la práctica educativa del marco teórico que brinda la perspectiva de género), la cual es uno de los objetivos recogidos el marco internacional de los ODS de Naciones Unidas. En España, la LOMLOE, en su preámbulo, subraya la importancia de la coeducación, la cual debe permear todas las etapas educativas, promoviendo la prevención de la violencia de género, el respeto a la diversidad afectivo-sexual y fomentando una orientación formativa y profesional que sea inclusiva y no sexista.

El caso Almendralejo abre el debate sobre el estado de la cuestión

El 18 de agosto de 2023 apareció en las noticias el conocido como “caso Almendralejo”. Este caso implicaba la creación y difusión de imágenes falsas de desnudos de menores creadas con herramientas con IAG en la localidad de Almendralejo, Badajoz. El 20 de octubre de 2023 aparecen más datos: un grupo de menores, de entre 12 y 14 años, había generado y distribuido imágenes falsas de desnudos de, al menos, 22 niñas de su entorno. Creadas utilizando herramientas con IAG, las imágenes se habían compartido a través de WhatsApp y Telegram. El caso tuvo una gran repercusión mediática, llegando incluso a tener cobertura internacional.

Este caso movilizó el debate sobre el estado de la cuestión. El 19 de agosto de 2023, VerificaRTVE publicó una guía para las víctimas de montajes pornográficos, con menciones a instituciones como los puntos de Atención Temprana a las Víctimas. Más adelante, el 23 de agosto de 2023, RTVE publicó un artículo abordando cómo se juzga en España el porno sintético sin consentimiento. En este artículo, se apunta que el 96% del contenido creado por IAG corresponde a pornografía no consentida, afectando casi exclusivamente a mujeres. En casos que involucran a menores, como el de Almendralejo, en los cuales se generaron imágenes falsas de desnudos de niñas, estos actos pueden considerarse delitos de pornografía infantil. El artículo pone énfasis en la necesidad de una actualización de las leyes para abordar eficazmente los retos que plantea la IAG en la creación de contenido sexual no consentido.

El 29 de septiembre de 2023, RTVE publicó otro artículo sobre esta temática, esta vez sobre la legislación de las herramientas con IAG. En este sentido, la Unión Europea está desarrollando regulaciones para reforzar la protección de los ciudadanos frente a ciberdelitos, incluyendo la implementación de filtros de edad y la obligación de informar sobre falsificaciones. Posteriormente, el 2 de octubre de 2023, Miriam Al Adib Mendiri, madre de una de las niñas afectadas y ginecóloga, ofreció una entrevista en la cual detalló cómo se había enterado del incidente y su decisión de no ignorar la situación. La doctora destacó la importancia de educar a los jóvenes sobre el uso responsable de la tecnología y la necesidad de apoyo a las víctimas.

Es a partir de este momento cuando empiezan a surgir casos similares reflejados en la prensa. El 24 de octubre de 2023 se identifica un incidente en Barcelona, seguido por otro en Madrid el 12 de julio de 2024 y un tercer caso en Sevilla el 5 de agosto de 2024. Las autoridades subrayan que, en muchos de estos casos, la identificación de los responsables resulta compleja. Además, no todas las víctimas presentan denuncias, lo cual contribuye a que numerosos casos pasen desapercibidos y no reciban cobertura mediática.

Aunque esta problemática no es nueva (herramientas de edición de imagen como Photoshop han sido popularmente utilizadas con estos fines), lo que sí ha cambiado es su escalabilidad. Las aplicaciones de IAG permiten generar imágenes manipuladas de manera rápida y con un alto grado de realismo. Esta facilidad de uso, combinada con la accesibilidad que ofrecen las aplicaciones web y móviles, amplía significativamente el número de usuarios que pueden utilizar estas herramientas, lo cual incrementa el alcance y el riesgo asociado a estas prácticas. Por ejemplo, el 29 de enero de 2024, RTVE reportó que las búsquedas de la cantante estadounidense Taylor Swift habían sido temporalmente bloqueadas en la red social X (anteriormente Twitter), para poder contrarrestar la inundación de deepfakes sexuales de la artista que habían sido compartidos en la plataforma durante la semana anterior.

¿Cómo de comunes son estas prácticas entre menores? En Estados Unidos, en agosto del 2024, la ONG Thorn publicó el informe Youth Perspectives on Online Safety 2023. La encuesta, realizada en línea entre el 3 de noviembre y el 1 de diciembre de 2023, formuló preguntas a 1.040 menores de entre 9 y 17 años sobre material sexual y experiencias dañinas en línea. Uno de los ítems que más captó el interés de la prensa fue el nuevo ítem QB4: “Que tú sepas, ¿alguno de tus amigos o compañeros de clase ha utilizado alguna vez herramientas de IA para generar desnudos de otros niños?

Figura 1. Captura del gráfico resultante del ítem QB4 del informe Youth Perspectives on Online Safety 2023.

El resultado fue de un notable 1 de cada 10, junto con otro 1 de cada 10 que prefirió no responder.

La encuesta de Thorn es uno de los primeros intentos en cuantificar el alcance del problema. El informe señala la necesidad de que la industria tecnológica aborde los riesgos de la IAG para los niños, pero enfatiza que esto no debe retrasar la intervención sobre los comportamientos dañinos asociados, como el bullying y el acoso. También destaca la importancia de un enfoque proactivo para abordar los daños causados por los deepfakes, y el refuerzo de la educación sobre conductas inaceptables en comunidades y escuelas, más allá de la tecnología utilizada (p. 13).

Además de los malos usos de las herramientas para modificar imágenes, otros usos de la IAG también plantean problemas éticos y de perspectiva de género que han sido recogidos en la prensa. Por ejemplo, el 21 de diciembre de 2023, RTVE informó sobre la creación de la influencer virtual Aitana López, desarrollada mediante IAG. La aparición y proliferación de estos usos comerciales subraya problemáticas relacionadas con la representación femenina, la explotación y la cosificación de las mujeres en entornos digitales, y contribuye a perpetuar la idea de las mujeres como objetos de consumo. Posteriormente, el 7 de marzo de 2024, RTVE abordó el concurso de belleza «Miss AI«, protagonizado por modelos generadas por IAG. Este caso no solo refuerza las preocupaciones sobre estereotipos de género y cosificación, sino que también plantea interrogantes sobre las implicaciones sociales y culturales de reemplazar a las mujeres reales por creaciones sintéticas, carentes de agencia y voz propia. Ambos ejemplos ilustran cómo estas tecnologías no solo replican, sino que amplifican dinámicas de desigualdad de género en los entornos digitales.

La capacidad de crear imágenes falsas y contenido sexualizado sin consentimiento, y de difundirlo a escala global, no es únicamente un problema técnico o legal. Este es, sobre todo, un problema social, ético y con un componente elemental de género. Las niñas y mujeres suelen ser las principales víctimas de estos abusos, viéndose expuestas a violencia de género digital, extorsión sexual (sextorsión) y daños irreparables en su reputación. Muchos de estos comportamientos nocivos surgen en entornos en los cuales los estereotipos, las actitudes sexistas y la falta de sensibilidad ante el consentimiento y el respeto a la dignidad ajena facilitan su aparición. La coeducación supone un vehículo para prevenir estas dinámicas. La formación en competencia digital y el fomento del pensamiento crítico adquieren una nueva dimensión cuando se trata de detectar, prevenir y responder a la creación de deepfakes y otros usos malintencionados de la IAG.

Como docentes, debemos ser conscientes sobre el hecho de que la raíz de este problema no radica únicamente en la curiosidad tecnológica del alumnado, sino en la falta de educación en valores, en el desconocimiento de las consecuencias legales y emocionales, y en la reproducción de estereotipos de género que trivializan la violencia digital contra las mujeres. En este contexto, la coeducación tiene un papel protagónico al subrayar la necesidad de entender estas prácticas como actos de violencia de género digital y no como simples “bromas” o “cosas de chicos”.

La interseccionalidad entre los usos éticos de la IA, ciudadanía digital y perspectiva de género

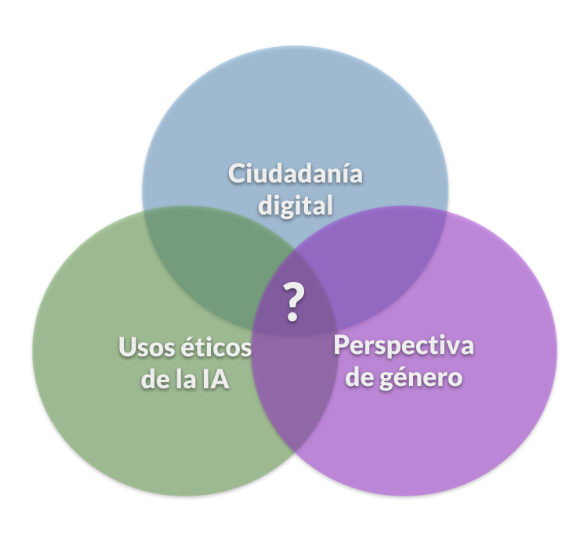

Figura 2. Diagrama de Venn sobre la interseccionalidad entre ciudadanía digital, usos éticos de la IA y perspectiva de género, con un interrogante en el centro.

Un concepto clave para entender esta situación es el de interseccionalidad. Los docentes nos estamos enfrentando a una problemática que combina usos éticos de la IA, ciudadanía digital y perspectiva de género. Docentes, familias y alumnado estamos descubriendo juntos, a la vez, cómo resolver este nuevo problema en la sociedad y en las aulas. Para dar respuesta, no basta con abordar cada uno de estos componentes de forma aislada. La confluencia de estas dimensiones crea un escenario complejo que exige respuestas igualmente complejas. No podemos limitarnos a mejorar la competencia digital del alumnado sin cuestionar los valores y actitudes que guían el uso de esas competencias.

La coeducación aporta una visión interseccional que tiene en cuenta cómo las desigualdades de género se entrelazan con las brechas digitales y con los usos problemáticos de la tecnología. Esta aproximación nos anima a replantear nuestro currículum, con tal de integrar la alfabetización mediática y digital con la educación afectivo-sexual y la sensibilización frente a la violencia de género. Al asumir esta responsabilidad, un centro educativo puede transformarse en un espacio de empoderamiento, en el cual el alumnado no solo aprenda a detectar deepfakes, sino también a rechazar prácticas digitales nocivas y a cuestionar problemas de género.

El problema de los deefakes cuenta, actualmente, con mucha menos visibilidad de la que sería necesaria en el panorama educativo sobre IA. Muchos divulgadores de IA en educación se sienten fuera de su zona de confort al abordar temas como este. Se teme que afrontar estas prácticas tenga un efecto contrario y fomente su uso, o que presente la IA bajo una luz negativa. Sin embargo, silenciar el problema nunca es la solución. La coeducación nos insta a enfrentarnos a estas realidades, a mostrar sus consecuencias y a proporcionar al alumnado las herramientas para reflexionar y actuar éticamente.

Riesgos específicos de los deepfakes

Para entender mejor el alcance de la problemática, Leon Furze, en su artículo We need to talk about deepfakes (2024), identifica los mayores riesgos de los deepfakes:

- Deepfakes explícitos creados sin consentimiento: la producción de imágenes o videos sexualizados sin el consentimiento de la persona retratada constituye una forma de violencia grave que atenta contra su dignidad y su intimidad.

- Chantaje, extorsión y sextorsión: la creación de contenido falso puede ser utilizada para coaccionar a las víctimas, exigiendo dinero o favores sexuales, entre otros tipos de coacciones, bajo la amenaza de difundir el material.

- Daño reputacional: un deepfake no solo humilla a la víctima, sino que puede destruir su reputación personal, escolar e incluso profesional, con consecuencias psicológicas devastadoras.

- Desinformación y “fake news”: más allá del ámbito escolar, los deepfakes también pueden alimentar narrativas falsas y manipular la opinión pública, lo cual puede socavar la confianza en la información veraz y en las instituciones.

¿Qué pueden hacer los centros educativos y los docentes ante esta situación? Furze propone una serie de medidas que, integradas en el marco de la coeducación, pueden ayudar a situar a los docentes:

- Legislación y criminalización: los centros educativos deben conocer las leyes que regulan los deepfakes, la violencia de género digital y la privacidad. Deben trabajar con el entorno jurídico y apoyar la aprobación de normativa que proteja a las víctimas y condenen a los responsables. La coeducación puede ayudar a contextualizar estas leyes en un marco restaurativo, evitando una visión meramente punitiva.

- Prevención y educación: promover campañas de concienciación y formación específica. Esto podría incluir charlas con expertos en ciberseguridad, talleres sobre consentimiento y privacidad digital, y la integración de estos contenidos en materias transversales.

- Políticas y gestión del riesgo: los centros educativos deben contar con protocolos claros para reaccionar ante casos de deepfakes. Estos protocolos deben especificar los pasos a seguir, a quién contactar, cómo proteger a la víctima y cómo garantizar un enfoque restaurativo. La coeducación asegura que estas respuestas no se limiten a la sanción, sino que incluyan la reflexión, la empatía y el cambio de actitudes.

- Apoyo a las víctimas: cuando un menor de edad es víctima de un deepfake, necesita apoyo inmediato de su entorno y asesoramiento psicológico, vías para denunciar la situación y ayuda para eliminar el contenido de la red. Desde la coeducación se enfatiza que cada caso es una oportunidad para el aprendizaje colectivo. La comunidad escolar debe mostrar solidaridad con la víctima y firme rechazo a la violencia, por tal de reforzar así el mensaje de que esas conductas no tienen cabida en un entorno educativo que aspira a la igualdad y el respeto.

La implicación de las familias en este objetivo

La inacción es el peor de los caminos. La realidad ya está ahí, con menores practicando este tipo de abusos. La ausencia de un abordaje formativo no evitará que ocurran, pero sí impedirá que el alumnado adquiera conciencia del daño que provocan y que se sienta preparado para evitarlos o denunciarlos.

El 18 de noviembre de 2024, Ars Technica publicó un artículo sobre un caso en una escuela de Pensilvania, Estados Unidos. En esa escuela, un alumno creó y difundió imágenes explícitas de casi 50 compañeras creadas con IAG. En agosto de 2024, el alumno fue arrestado. Indignados por la inacción de la escuela, las familias de las víctimas presentaron una demanda, exigiendo la renuncia de los cargos directivos. Ante la presión, la escuela se vio forzada a cancelar las clases temporalmente y ofreció apoyo a la comunidad. A pesar de esto, las familias siguieron adelante con la demanda por la falta de respuesta adecuada por parte del centro ante el abuso sufrido por las alumnas.

La implicación de las familias en este discurso es básica, ya que son el primer espacio donde se inculcan valores de respeto e igualdad. Al trabajar en conjunto con el centro educativo, se refuerza la idea de un uso responsable de la tecnología, y se puede concienciar a los menores sobre los peligros de crear o distribuir contenidos inapropiados generados con IAG. Esta colaboración puede ayudar a que el alumnado comprenda las implicaciones éticas de estas tecnologías y fomente una ciudadanía digital que respete los derechos de todas las personas. Se puede movilizar, por ejemplo, de manera síncrona, a través de la implementación de talleres y charlas formativas, o de manera asíncrona a través de la publicación de guías y recursos formativos. Solo con un esfuerzo conjunto entre familias, docentes y alumnado se puede garantizar que la IAG sea una herramienta que promueva la equidad y no perpetúe desigualdades ni violencias de género.

El papel ejemplarizante del docente

Los docentes debemos formarnos no solo en los aspectos técnicos de esta tecnología, sino también en su usos desde la perspectiva de género. A pesar de que pueda ser incómodo, es imprescindible. Los docentes tenemos la responsabilidad de ser referentes éticos y de mostrar una actitud comprometida con la igualdad y la justicia social.

Existe amplia literatura sobre la importancia de construir un espacio seguro en educación. Por ejemplo, en el artículo Cultivating the Classroom as a Safe Space for Middle and High School Students del blog Edutopia (2021), Fievre destaca la importancia de crear entornos de aprendizaje en los cuales el alumnado pueda sentirse libre para cometer errores sin temor a juicios o al ridículo, y pueda participar de forma crítica y honesta cuando se traten temas sensibles. Además, pone en relieve aspectos como mostrar compasión y comprensión, especialmente en momentos de crisis.

En cuanto a tratar temas sensibles en el aula, en el artículo de Edutopia Creating a Safe Space for Students to Discuss Sensitive Current Events (2015), Alrubail propone estrategias como informar sobre los recursos disponibles, fomentar reflexiones escritas, proporcionar lecturas relacionadas, facilitar debates en grupo o fomentar la reflexión personal. De manera relacionada, Bowerman, en su artículo Building a Trauma-Sensitive Space (2023), enfatiza la importancia de proporcionar al alumnado espacios seguros donde puedan retirarse cuando sufren estrés o crisis emocionales. Al proporcionar estos espacios dentro del entorno escolar, se reconoce y valida la necesidad del alumnado de tener un lugar para procesar sus emociones, lo cual puede contribuir a su bienestar general y a crear un ambiente de aprendizaje más inclusivo y comprensivo.

El alumnado necesita saber que puede hablar de estos temas con los docentes, que estos no los juzgarán ni minimizarán el problema, sino que ofrecerán acompañamiento y soluciones. La coeducación vuelve a ser una brújula: debemos utilizarla para guiarnos en la creación de entornos seguros, libres de discriminaciones y violencias.

Conclusiones

Los deepfakes, la posibilidad de generar imágenes sin consentimiento y las múltiples formas de abuso digital asociadas a la IAG nos interpelan como docentes. No podemos ignorar estos fenómenos, ni diluirlos en un discurso meramente técnico. La coeducación ofrece uno de los marcos más importantes para abordar el uso ético de la tecnología, el respeto a la dignidad humana y la promoción de relaciones igualitarias, con el objetivo de prevenir y erradicar estas nuevas formas de violencia.

En este contexto, es fundamental que los centros educativos tomen medidas concretas para integrar la coeducación y la alfabetización mediática en sus prácticas. Desde talleres sobre ciudadanía digital hasta proyectos colaborativos que fomenten el pensamiento crítico, cada iniciativa cuenta para formar a un alumnado consciente y empático. Invitamos a docentes, familias y responsables educativos a unirse en el diseño de estrategias que no solo sensibilicen sobre los riesgos de la IAG, sino que también promuevan un uso responsable y equitativo de estas tecnologías. La educación es la herramienta más poderosa que tenemos para transformar estos retos en oportunidades de aprendizaje y crecimiento.

Al integrar la coeducación en la formación sobre IAG, estamos construyendo una cultura digital más justa y consciente, capaz de abordar los retos sin perder de vista los principios básicos de la dignidad, el respeto y la igualdad. Este es el camino para que el centro escolar, en su papel formador, acompañe a las nuevas generaciones en la construcción de un futuro digital inclusivo y ético. De esta manera, podremos formar ciudadanos que entiendan que la tecnología, usada de manera responsable y con perspectiva de género, es un medio para el progreso social y no una herramienta de abuso. Y ese sería, en última instancia, uno de los mayores logros educativos que podemos aspirar a conseguir.

Referencias bibliográficas

Alrubail, R. (2015). Creating a safe space for students to discuss sensitive current events. Edutopia. Recuperado de https://www.edutopia.org/discussion/creating-safe-space-students-discuss-sensitive-current-events

Bray, B. & McClaskey, K. en Beresford, T. (2017). Human-scale at scale: Cultivating new education cultures. Innovation Unit. https://www.innovationunit.org/wp-content/uploads/Human-scale-at-Scale_report_FINALcompressed.pdf

Bowerman, M. J. (2023). Building a trauma-sensitive space. Edutopia. Recuperado de https://www.edutopia.org/article/creating-trauma-safe-spaces-in-school/

Cernadas, E., & Calvo-Iglesias, E. (2020). Gender perspective in artificial intelligence (AI). Eighth international conference on technological ecosystems for enhancing multiculturality (pp. 173-176). https://dl.acm.org/doi/abs/10.1145/3434780.3436658

Fievre, M. J. (2021). Cultivating the classroom as a safe space. Edutopia. Recuperado de https://www.edutopia.org/article/cultivating-classroom-safe-space/

Furze, L. (2024). We need to talk about deepfakes. Recuperado de https://leonfurze.com/2024/09/11/we-need-to-talk-about-deepfakes/

Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura. (2017). Educación para los Objetivos de Desarrollo Sostenible: objetivos de aprendizaje. UNESCO. https://unesdoc.unesco.org/ark:/48223/pf0000250057_spa

Scheuerman, M. K., Paul, J. M., & Brubaker, J. R. (2019). How computers see gender: An evaluation of gender classification in commercial facial analysis services. Proceedings of the ACM on Human-Computer Interaction, 3(CSCW), 1-33. https://dl.acm.org/doi/abs/10.1145/3359246Thorn. (2024). Youth perspectives on online safety, 2023. https://info.thorn.org/hubfs/Research/Thorn_23_YouthMonitoring_Report.pdf