DESARROLLO INCLUSIVO Y DIVERSIDAD EN LA INTELIGENCIA ARTIFICIAL

Investigadora Postdoctoral, Doctora en Sociología, Equidad, Diversidad e Inclusión en el Barcelona Supercomputing Center (BSC). Investigación sobre el Impacto Social de la Inteligencia Artificial (IA), Perspectiva de sexo, género y diversidad en IA. Miembro de Organization for Women in Science for the Developing World (OWSD), Alianza <A+> por Algoritmos Inclusivos y Embajadora de Women in Data Science Stanford en España.

La Inteligencia Artificial (IA) es uno de los principales desafíos de la sociedad de hoy y del futuro. Muchas de las decisiones que las personas consideran propias ya están determinadas por algoritmos, sistemas basados en IA que configuran nuestras democracias, políticas sociales, sistemas de salud, y hasta decisiones más cotidianas como la elección de una canción, una película, planificación de viajes, recomendaciones de hoteles, seguros, etc. (Helbing y Pournaras, 2015). Si bien los avances tecnológicos brindan muchas oportunidades, necesitamos que estos sistemas de información sean transparentes, confiables y centrados en el usuario para proporcionar aplicaciones útiles, en beneficios de todas las personas (Becerik-Gerber, et al. 2022; Obrist, et al. 2023; Koster et al. 2022). También es clave tener un diseño inclusivo que refleje la realidad social y que sea representativo de las distintas características de la ciudadanía, para resolver los problemas y necesidades de todo ella y no únicamente de una parte de esta, generando nuevas desigualdades sociales y/o perpetuando las existentes.

La IA tiene incidencia en muchos sectores, tal como en la producción, el gobierno, medio ambiente, la educación, la salud y otros múltiples espacios, lo que requiere de evaluaciones de impacto. Con cada sistema es fundamental examinar el riesgo del uso indebido y las implicaciones sociales no deseadas, para no reproducir estereotipos y no excluir a la ciudadanía (No author listed, 2019). El gran desafío es adecuar a los sistemas de IA, aplicaciones personalizadas y efectivas, que consideren las distintas variables socioeconómicas de cada individuo para lograr aplicaciones de IA con precisión, que garanticen los Derechos Humanos y la orientación de la misma a la consecución de los Objetivos de Desarrollo Sostenible (Buslón et al. 2022; UNESCO, 2021).

Existen múltiples guías éticas de IA en el mundo. En noviembre del 2021, los 193 Estados miembros de la UNESCO adoptaron el primer acuerdo mundial sobre la Ética de la IA como primer instrumento normativo mundial, no sólo para proteger sino para promover los Derechos Humanos y la dignidad, y para generar una base normativa global que permita construir un sólido respeto por el estado de derecho en el mundo digital (UNESCO, 2021). Los principios que se establecen son:

- Proporcionalidad e inocuidad.

- Seguridad y protección.

- Equidad y no discriminación.

- Sostenibilidad.

- Derecho a la intimidad y protección de datos.

- Supervisión y decisión humana.

- Transparencia y explicabilidad.

- Responsabilidad y rendición de cuentas.

- Sensibilización y educación.

- Gobernanza y colaboración adaptativas y de múltiples partes interesadas.

Asimismo, las recomendaciones del consejo de la OCDE de 2019 sobre la IA para políticas y estrategias públicas en todo el mundo, constatan que es fundamental para un crecimiento inclusivo, desarrollo sostenible y bienestar:

- La promoción de valores y equidad centrados en el ser humano.

- La transparencia y explicabilidad.

- La robustez, seguridad y protección de datos de los sistemas.

- El desarrollo responsable.

- La rendición de cuentas.

- La resiliencia y

- La mitigación de sesgos dañinos

(OECD, 2019; OECD/CAF, 2022).

La IA tiene que brindar soluciones a la sociedad libre de sesgos, que garantice el uso responsable en la población. Por lo que las iniciativas y proyectos actuales tienen que orientarse en buscar estrategias y formación adecuada para identificar los sesgos y desarrollar sistemas seguros.

La construcción de sistemas con interacción humana, conocidos como HBI-Human-Building Interaction, se muestra como una gran herramienta de innovación. El HBI es un campo convergente que representa la complejidad y necesidad de una interacción dinámica entre la experiencia humana y la inteligencia artificial, dentro de los entornos construidos como visión general para el futuro. Las áreas que contribuyen y de las que se requiere atención en este proceso son: los seres humanos (experiencias, desempeño y bienestar); la construcción (diseño, operaciones) y las tecnologías (definición, conciencia, inferencia): los procesos que determinarán la toma de decisiones; la confianza y la colaboración en los modelos de IA (Becerik-Gerber et al., 2022).

Dentro de estos modelos, la perspectiva de sexo, género e interseccionalidad es un aspecto fundamental que tiene que estar presente en esta construcción, para garantizar la justicia en los sistemas algorítmicos para todas las personas independientemente de su género, raza, cultura, nivel socioeconómico, edad o nivel educativo, entre otras variables que nos definen como personas.

La diversidad social y la formación en estos ejes tendrá un impacto en la determinación de la participación y diseño, así como en la toma de decisiones, desarrollo y evaluación de los modelos de IA. El éxito a largo plazo de la IA depende del reconocimiento e implicación de las personas en su diseño, operación y uso. Considerar la diversidad en los equipos de trabajo, la participación durante el proceso de desarrollo en los usuarios seleccionados e incluso en las referencias bibliográficas (autorías, nacionalidades) o en agregación de los datos y definición de los resultados, nos permitirá asegurar una planificación, co-creación y aplicación adecuada. Se ha de pensar en un modelo que incluya un cambio a nivel educativo, de gobernanza, y de industria para transformar el desarrollo científico y tecnológico de la IA.

- Sesgos en Inteligencia Artificial

Considerando el potencial transformador en nuestra sociedad que tiene la IA, es necesario diseñar políticas que aboguen por el control y la precaución sobre los riesgos de sesgos y discriminación por parte de empresas, gobiernos, academia y ámbito tecnológico, involucrados en el ecosistema de la IA.

Un sesgo se define como un prejuicio a favor o en contra de una cosa, persona o grupo en comparación con otro, generalmente de manera injusta o negativa. Aunque ha habido intentos de controlar los usos malintencionados y poco éticos de los datos, y de abrir las “cajas negras” de los algoritmos para garantizar que no se produzcan daños intencionados y no intencionados, gran parte de los sistemas que encontramos en nuestra vida cotidiana siguen teniendo problemas por resolver. El sesgo inconsciente, también conocido como sesgo implícito, se define como el conjunto de actitudes y estereotipos que influyen en el juicio, la toma de decisiones y el comportamiento, de manera que están fuera del conocimiento y/o control consciente (Harvard/ODIB, 2021).

Existen múltiples formas de clasificar los sesgos en los sistemas de computación. Según Friedman y Nissenbaum (1996) se pueden identificar como sesgos preexistentes, técnicos y emergentes. El sesgo preexistente tiene su origen en los valores, prácticas y actitudes de las instituciones, por lo que su abordaje requiere un cambio cultural, y una revisión de las estructuras de participación en el desarrollo de la tecnología. El sesgo técnico surge de restricciones técnicas o consideraciones en el desarrollo, que puede ser en los datos, en el proceso estadístico, o en el propio desarrollo tecnológico. Finalmente, el sesgo emergente se relaciona con el contexto de uso en el que éste se aplica y necesita una adaptación a la sociedad y el ambiente para no tener fallas en su impacto.

Desde la perspectiva de sexo, género e interseccionalidad, uno de los riesgos de la IA es que pueda producir discriminación social y una importante pérdida de confianza por parte de la población, si no son identificados o mitigados los sesgos en el ámbito tecnológico. Así, un sistema basado en IA puede llegar a reproducir resultados sexistas o racistas (Zou & Schiebinger, 2018). Se produce discriminación cuando un algoritmo, o los datos de entrenamiento históricos a partir de los cuales aprende, contienen errores que llevan a tratar distintamente, sin justificación aceptable, a personas o grupos con respecto al resto de la población. El impacto de la replicación y perpetuación sistemática de sesgos se amplifica cuando sistemas que los incorporan son utilizados, causando daños a las comunidades subrepresentadas, por lo que construir un entendimiento común de la IA para mitigar sesgos y mejorar la prestación de servicios sociales es uno de los retos más importantes.

En el ámbito de la salud, ignorar el sexo biológico y el género, a nivel social, puede conducir a un acceso reducido a la atención médica, a un tratamiento retrasado o no adecuado y a una peor salud de la población. El sexo biológico y el género impactan en la investigación básica, en los estudios preclínicos y en la salud pública. Esto ocurre, por ejemplo, cuando una máquina concebida para detectar los cánceres de la piel únicamente ha sido entrenada únicamente con un tipo de personas (p.e. hombres de pieles claras), por lo que no detectará con la misma fiabilidad los cánceres en pieles en mujeres de piel más morena UNESCO (2020). Estudios recientes de la Universidad de MIT y Microsoft Research señalan que los algoritmos de aprendizaje automático pueden discriminar por raza y género, lo que plantea desafíos que requieren perspectivas éticas desde la interseccionalidad para manejar modelos que incorporan prejuicios humanos (Buolamwini & Gebru, 2018).

En el ámbito laboral, la discriminación en sistemas de IA puede llevar a empeorar la situación de la mujer en STEM (Science, Technology, Engineering, Mathematics) y STEAM (Science, Technology, Engineering, Art, Mathematics), excluyéndolas de las oportunidades laborales más ventajosas. Esto ya ha sucedido en casos en que diseños de reclutamiento automático, al revisar los currículos de las personas solicitantes con el objetivo de mecanizar la búsqueda de los mejores talentos científicos, se enseñaron por sí mismos que los candidatos masculinos eran preferibles (dado que se mencionan con más frecuencia científicos famosos que científicas), penalizando los currículums que incluían la palabra “femenino” (Dastin, 2018). También en el ámbito financiero los sistemas de algoritmos pueden marcar preferencia en quienes conceden créditos, predeterminados por el género, y limitar así la solvencia crediticia de un cliente.

De este modo, los sesgos en la IA se pueden crear por fenómenos como discriminación pasada, desbalance de clase, fuga de información, cambios temporales y sobreajuste, entre otros impactos que afectan en la toma de decisiones en una política pública, sistema o aplicación con alcance social (Cabrol, et al., 2020). Trabajar en la participación humana y con perspectiva de sexo, género e interseccionalidad en las distintas fases de desarrollo (ex-ante, in itinere y ex post) de los sistemas de IA con un enfoque ético, socioeconómico, y cultural que incorpore prácticas responsables de diseño, desarrollo y uso de la tecnología contribuirá a conseguir sistemas de IA confiables y representativos de la población. Es decir, a favorecer desarrollos que planteen una revisión en los criterios, enfoque de investigación, en las prácticas, preguntas, hipótesis, métodos, conformación de equipos, explicabilidad en datos, formación y aplicabilidad en procesos.

- Desarrollo Inclusivo en IA

Para lograr un desarrollo inclusivo de la IA, es necesario repensar el diseño global de las ciencias y las ingenierías con el rol de la sociedad en el mismo. Tal como plantea Tannenbaum, (Tannenbaum et al. 2019) se debe divisar la responsabilidad de cada sector y establecer estrategias a nivel de tres pilares:

- Agencias de financiación,

- Universidades y

- Revisiones en publicaciones científicas.

Se debe, además, incorporar a los gobiernos, la industria, al sector público y privado, entre otras esferas fundamentales, en el proceso del desarrollo científico y tecnológico.

Es así que, las agencias nacionales de investigación y el sistema educativo son responsables de promover la investigación y formación de excelencia que beneficie a toda la sociedad. La integración de esta perspectiva, en el diseño de la investigación, de las tecnologías, potenciará la excelencia en ciencia y podrá desarrollar una IA que responda mejor a las necesidades sociales, aportando mejoras en la calidad de vida de las personas, orientada en reducir y eliminar las desigualdades sociales (Tannenbaum et al., 2019; Hunt et al., 2022).

D’Ignazio y Klein (2020) plantean que es necesario implementar una nueva forma de pensar la IA, la ciencia de datos y la ética de datos, con una orientación con perspectiva de género, interseccionalidad y feminismo para respaldar el desarrollo ético. La diversidad está conectada con este desarrollo inclusivo que se marca como el medio efectivo para la mejora del acceso y calidad de los sistemas de IA.

En consecuencia, los datos se extraen de las personas y comunidades, por lo que deben tener una alineación con los seres humanos y sus mejores conductas. Lo que genera una profunda asimetría son las desigualdades entre quién recopila, almacena, analiza, y visualiza los datos, y los valores que impulsan la sociedad. Es necesario representar en estos modelos a las mujeres y grupos minoritarios excluidos por el sesgo de la IA. También debemos potenciarlo a nivel de universidades, gobiernos y corporaciones para tener un sector laboral, económico y de desarrollo tecnológico más justo y representativo. Cualquier sistema que se desarrolle o implemente debe seguir una determinación ética en relación con su impacto social en la población.

Formar a la sociedad y fomentar la co-creación en los procesos de desarrollo de IA permitirá garantizar la protección de Derechos Humanos en la regulación y garantía de libertades individuales, al establecer límites claros en el uso de la IA. De este modo, la regulación puede ayudar a prevenir daños hacia las personas y la sociedad, al regular el uso de tecnologías potencialmente peligrosas y prevenir sesgos. Contar con una participación social inclusiva y diversa nos brindará una visión más eficaz en el diseño, que evitará introducir sesgos en los modelos.

De esta forma el proceso otorgará más transparencia a estos sistemas en el uso de la IA y podrá definir que los algoritmos sean explicables y auditables. Además, tener un proceso participativo que promueva mecanismos y herramientas de evaluación ex-ante, in itinere y ex post potenciará la confianza en la tecnología de IA, al establecer estándares éticos y técnicos claros durante todo el desarrollo. A su vez, esta definición genera un proceso responsable, en el que la sociedad puede establecer responsabilidades claras para las personas desarrolladoras y los usuarios. También genera innovación, ya que la inclusión de distintas perspectivas brinda nuevas oportunidades y permite visualizar nuevas ideas y aplicaciones y proyectar vías de escalabilidad, creación de nuevos puestos de trabajo y sostenibilidad financiera.

- Aspectos éticos y sociales en ciencias informáticas

Tener una visión global de las consecuencias, limitaciones e impactos injustos de la informática en la sociedad es fundamental para garantizar una IA justa e inclusiva. Analizar y definir nuevos estándares, nuevo lenguaje y nuevos sistemas de trabajo remarca nuevos métodos de trabajos que se adecuan a los marcos éticos de IA, en el desarrollo y aplicación de la tecnología focalizada en los humanos, en las personas y sus características, lo cual es un reto para transformar problemas y evitar nuevas amenazas.

La educación de ciencias informáticas pone en manifiesto que la especialización de áreas de conocimiento ha hecho perder la visión global y conexión del saber científico personalizado con distintas esferas. Los datos son responsables de muchos de los sesgos de la informática, ya sea directamente por su recogida o indirectamente por la aplicabilidad (Ko, et al. 2020). Por ello, la multidisciplinariedad y diversidad en los equipos de trabajo es un aspecto potencial cuando trabajamos con datos y desarrollo de sistemas de IA para tener una perspectiva de las implicaciones. De este modo se requiere que las personas que trabajan en ciencias informáticas reciban formación sobre los aspectos éticos y sociales, perspectiva de sexo, género y diversidad, durante su formación universitaria, para aplicarlos en sus sistemas y avanzar en un desarrollo más inclusivo de las ciencias.

Actualmente, los cursos de informática se centran únicamente en la programación técnica y los enfoques matemáticos, no logrando preparar al estudiantado para comprender cómo las tecnologías influyen en los sistemas legales, gobiernos, sistemas económicos y culturales. La incorporación del análisis de sexo, género, diversidad e interseccionalidad en los cursos básicos de informática puede mejorar las habilidades críticas de profesionales en el área de la IA, con la capacidad de reconocer las injusticias sistémicas perpetuadas por la tecnología y preparar mejor a la fuerza laboral científica para el futuro (Ko, et al., 2020).

Fomentar el conocimiento en ciencias de informática inclusivo y responsable se ha convertido en una de las prioridades a nivel internacional. Las guías éticas mencionadas, como las de la UNESCO (2021) y la OECD/CAF (2022), al igual que se aplicación desde la Unión Europea (Schiebinger & Klinge 2020), están alineadas en torno al objetivo principal de brindar formación y educar a las personas responsables en computación de los desarrollos tecnológicos en torno al impacto de la IA en la población (Stanford University, 2020). De este modo, se plantea como vital que la comunidad de investigación informática pueda abordar los desafíos éticos y sociales que surjan con la IA anticipando los riesgos sociales desde el principio. Y para ello se precisa disponer de formación con una perspectiva que incluya dimensiones sociales, políticas y económicas en las primeras etapas de investigación para reducir daños potenciales (Grosz et al., 2019; Horton, et al. 2022; National Academies of Sciences, Engineering, and Medicine, 2022).

El proyecto Gendered Innovations de Stanford (Stanford University, 2020) es el marco de referencia mundial sobre la perspectiva de sexo, género e interseccionalidad en ciencia que impulsa el valor en la investigación e ingeniería, en la sociedad y negocios. El mismo destaca la relevancia del proyecto “Embedded EthiCS” (Grosz, et al , 2019; Harvard University, 2019) como uno de los principales ejemplos en USA y el mundo en integrar el razonamiento ético en los cursos básicos de ciencias de la computación. Es un modelo que apunta a una computación responsable e inclusiva, que incorpora un análisis sociocultural que potencia habilidades de las humanidades y ciencias sociales en la formación técnica.

Actualmente existen diversas iniciativas en el mundo, tal como indica Gendered Innovations (en Stanford, Mozilla, University of Buffalo, Georgia Tech, MIT, Columbia University, etc.), que integran la ética en las clases de informática y en los planes de estudio. A nivel local, mencionamos el trabajo que se realiza en el Barcelona el Supercomputing Center desde el año 2021, con el diseño de cursos sobre el análisis de sexo, género e interseccionalidad en ciencia, con diapositivas, tareas, notas y ejemplos de herramientas de datos, accesibles para estudiantes de doctorado en ciencias de la computación, bioinformática, ciencias de la tierra e informática aplicada (Barcelona Supercomputing Center, 2023). Este módulo hace referencias a sesgos que se han encontrado en IA con características de género, edad, nivel socioeconómico, etc., analizando guías éticas de referencia, para constatar ejemplos de aplicación en medicina personalizada y otras esferas de trabajo. El objetivo es que el alumnado de doctorado puedan aplicar esta perspectiva en el proceso científico: desde la selección de referencias de trabajo, la definición de equipos diversos e inclusivos, la definición de sus preguntas de investigación, hipótesis, definición de datos, análisis, participación social de usuarios en el desarrollo, hasta la difusión en conferencias, atención a referencias bibliográficas, etc.

Este proceso y los distintos métodos de formación buscan fomentar un cambio crítico en las ciencias informáticas, en el razonamiento ético y social como una habilidad esencial para las personas que trabajan en los sistemas de IA. Los cursos que se diseñan tienen como objetivo aplicar estos conceptos en las universidades, empresas, etc. será cambiar el pensamiento y la definición de la tecnología a través de una visión más centrada en la construcción de sistemas con interacción humana.

- Buenas prácticas de desarrollo inclusivo en IA

Los estudios de las Naciones Unidas (West et al., 2019) han alertado del peligro de reproducir estereotipos de género en las tecnologías. Las cuestiones de género abordan debates con más fuerza a medida que la IA tiene mayor capacidad de incidencia en la sociedad y capacidad de comunicación similar a las humanas. Realizar voces femeninas como asistentes virtuales, reafirmando la visión de mujeres como ayudantes, o robots que tienen formas masculinas cuando son para mostrar ejemplos de eficacia y autoridad, son acciones que refuerzan los estereotipos de género y se señalan como algunos de los riesgos en el desarrollo tecnológico.

En la Figura 1 encontramos una alternativa a las voces de asistentes virtuales que conocemos como Alexa de Amazon, Siri de Apple, o el asistente de Google con voz que responde a femenina. Q es un diseño realizado por un equipo de investigación en IA que tiene una voz de género neutra (https://www.genderlessvoice.com/). Uno de los puntos claves para este equipo de trabajo era contribuir a una conversación global sobre los sesgos de género, tecnología y aspectos éticos. En palabras de Carpenter, J buscaban: “...cómo ser inclusivos para las personas que se identifican de muchas maneras diferentes” (Mortada, 2019; Simon,2019). La voz Q fue desarrollada como parte de las iniciativas del Orgullo Copenhague (Copenhagen Pride, 2020) y otros líderes de la iniciativa EqualAI (EqualAI, 2023), siguiendo un esquema de trabajo colaborativo, en un equipo de investigación, junto a diseñadores de sonido y lingüistas. Durante este trabajo lograron diseñar un nuevo sistema de IA que rompe con esquemas establecidos por las grandes empresas privadas que ofrecen servicios de asistencia virtual.

Es clave destacar que para el proceso de diseño y desarrollo del sistema de IA se grabaron y participaron docenas de personas con distintos perfiles, que se identifican en distintos géneros, (mujeres, hombres, transgénero y no binarios), por lo que su trabajo fue un claro ejemplo de sistemas de IA inclusivos y diversos que aplicaron un sistema de co-creación durante todo el proceso de trabajo, la fase inicial, proceso de trabajo y pruebas de cierre. La meta final se cumplió, obteniendo una voz de género neutro, ahora el segundo paso será que logremos escuchar a Q como opción de voz en las voces de asistencia virtual en el mundo (Mortada, 2019). [Figura 1].

Figura 1. Meet Q – Asistente de voz de género neutro

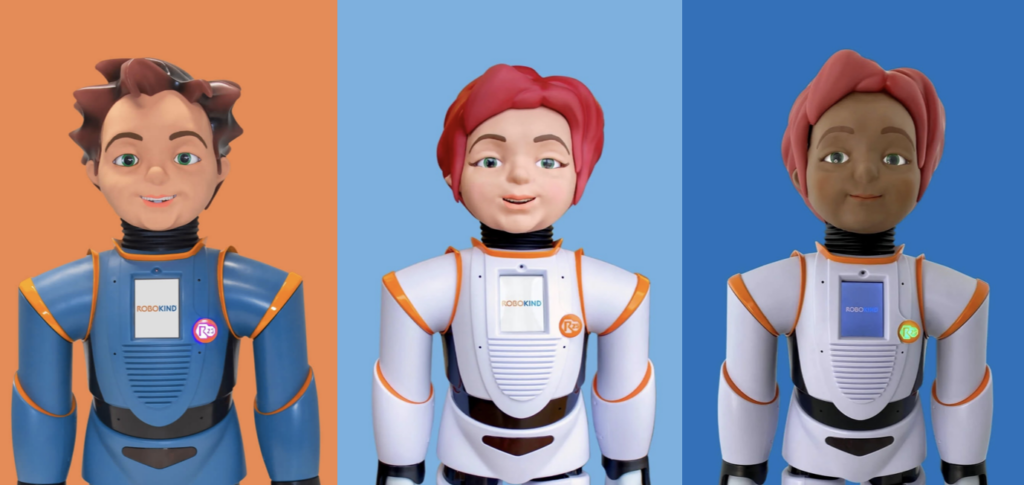

En la Figura 2 encontramos a Milo, Jemi, Veda, tres robots que tienen la intersección entre variables como género, discapacidad y origen étnico. Este robot fue diseñado por Robokind (Schiebinger et al., 2020; Silvera-Tawil, et al. 2020) para el tratamiento del espectro autista (ASD). En este caso, se ofrecen distintas opciones considerando la diversidad de pacientes y teniendo en cuenta que la identificación es positiva para la interacción. Los modelos que aplica Robokind parecidos a niñas, niños distintos e inclusivos dan herramientas educativas útiles y muestran que podemos crear robots personalizados que priorizan la igualdad de género y evitan estereotipos humanos.

Figura 2. Milo, Jemi, Veda. Robot social para tratamiento del espectro autista (ASD)

En este sentido, la educación sobre aspectos éticos y sociales en la formación en ciencias de la computación, la participación de las personas en el diseño de la IA, así como la perspectiva de sexo, género e interseccionalidad durante todo el proceso de diseño, desarrollo y aplicación de la IA, potenciarán un cambio importante en la tecnología. El objetivo será tener una perspectiva más amplia en que las personas puedan manifestar sus necesidades y experiencias y que estos conocimientos sean aplicados en el diseño y sistemas de IA para cumplir con los objetivos y valores prioritarios expuestos.

Transformar el esquema de diseño, la interacción con las personas usuarias y la formación plantea un giro en la responsabilidad, accesibilidad, confianza y calidad de los sistemas de IA. Todos estos aspectos garantizarán que tengamos modelos más justos, éticos, accesibles y de alta calidad que transformen positivamente la sociedad futura.

Bibliografía y enlaces relacionados

Barcelona Supercomputing Center (2023) PhD Programmes and Graduate Committee [Internet]. BSC-CNS. https://www.bsc.es/education/predoctoral-phd/phd-programmes

Becerik-Gerber, B., Lucas, G., Aryal, A., Awada. M., Bergés, M., Billington, S., Boric-Lubecke, O., Ghahramani, A., Heydarian, A., Höelscher, C., Jazizadeh, F., Khan, A., Langevin, J., Liu, R., Marks, F., Mauriello, M.L, Murnane, E., Noh, H., Pritoni, M., Roll, S., Schaumann, D., Seyedrezaei, M., Taylor, J.E., Zhao, J., Zhu, R.. (2022). The field of human building interaction for convergent research and innovation for intelligent built environments. Sci Rep. 2022 Dec 21;12(1):22092. doi: 10.1038/s41598-022-25047-y. PMID: 36543830; PMCID: PMC9769481.

Buolamwini, J. & ; Gebru, T.. (2018). Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification. In Proceedings of the 1st Conference on Fairness, Accountability and Transparency (2018) in Proceedings of Machine Learning Research, PMLR 81: pp. 77-91 https://proceedings.mlr.press/v81/buolamwini18a.html.

Buslón N, Racionero-Plaza S, Cortés A. (2022) Chapter 2 – Sex and gender inequality in precision medicine: Socioeconomic determinants of health. En: Cirillo D, Catuara-Solarz S, Guney E, editores. Sex and Gender Bias in Technology and Artificial Intelligence [Internet]. Academic Press; 2022 pp. 35-54.: https://www.sciencedirect.com/science/article/pii/B9780128213926000054

Cabrol, M., González A.N., Pombo, C., Sánchez, A.R., (2020) fAIr LAC: Adopción ética y responsable de la inteligencia artificial en América Latina y el Caribe [Internet]. Inter-American Development Bank; 2020 Ene. DOI: http://dx.doi.org/10.18235/0002169

Copenhagen Pride. (2020). Copenhagen Pride HeartCore – The Official Copenhagen Pride Magazine. [Internet]. https://www.copenhagenpride.dk/en/magazine/

Dastin, J. (2018) Amazon scraps secret AI recruiting tool that showed bias against women. Reuters [Internet]. 10 de octubre de 2018 https://www.reuters.com/article/us-amazon-com-jobs-automation-insight-idUSKCN1MK08G

D’Ignazio, C. & Klein, L.F. (2020) Data Feminism [Internet]. The MIT Press. 10/03/2020. http://mitpress.mit.edu/9780262044004/data-feminism/

EqualAI (2023). Leading the movement for innovative, responsible, and inclusive artificial intelligence.[Internet] https://www.equalai.org/

Friedman B, and Nissenbaum H. (1996). Bias in computer systems. ACM Trans Inf S yst. 1 de julio de 1996;14(3):330-47. 1 de julio de 1996;14(3): pp. 330-347.Helbing D, Pournaras E. (2015) Society: Build digital democracy. Nature. 5 de noviembre de 2015; 527(7576): pp. 33-34. doi: 10.1038/527033a.

Grosz, B.J., Grant, D.G., Vredenburgh, K., Behrends, J., Hu, L., Simmons, A., et al. (2019) Embedded EthiCS: integrating ethics across CS education. Commun ACM. 24 de julio de 2019;62(8): pp.54-61.

Harvard/ODIB (2021) ODIB Glossary: Equity, diversity, access, inclusion & belonging. Foundational Concepts & Affirming Language https://edib.harvard.edu/files/dib/files/oedib_foundational_concepts_and_affirming_language_12.7.21.pdf?m=1638887160 https://edib.harvard.edu/dib-glossary

Harvard University (2019). Embedded EthiCS @Harvard: Bringing ethical reasoning into the computer science curriculum. [Internet: Web y vídeo]. Harvard University. Team: Grosz, B., Simmons, A., Behrends, J., Chong, S., Mickens, J., Vadhan, S., Wattenberg, M. https://embeddedethics.seas.harvard.edu/home

Horton D, McIlraith SA, Wang N, Majedi M, McClure E, Wald B. (2022) Embedding Ethics in Computer Science Courses: Does it Work? En: Proceedings of the 53rd ACM Technical Symposium on Computer Science Education – Volume 1, 2022 [Internet]. New York, NY, USA: Association for Computing Machinery, p. 481-7. (SIGCSE 2022; vol. 1). https://doi.org/10.1145/3478431.3499407

Hunt L, Nielsen MW, Schiebinger L. (2022) A framework for sex, gender, and diversity analysis in research. Science. 30 de septiembre de 2022;377(6614):1492-5.

Ko, A.J., Oleson, A., Ryan, N., Register, Y., Xie, B., Tari, M., et al. (2020) It is time for more critical CS education. Commun ACM. 22 de octubre de 2020;63(11):31-3.

Koster R, Balaguer J, Tacchetti A, Weinstein A, Zhu T, Hauser O, et al. (2022) Human-centred mechanism design with Democratic AI. Nat Hum Behav. 6 de octubre de 2022; 6(10):1398-407.

Mortada, D., & Meet, Q., (2019). The Gender-Neutral Voice Assistant. NPR [Internet]. 21 de marzo de 2019 https://www.npr.org/2019/03/21/705395100/meet-q-the-gender-neutral-voice-assistant

National Academies of Sciences, Engineering, and Medicine. (2022). Fostering Responsible Computing Research: Foundations and Practices. Washington, DC: The National Academies Press. https://doi.org/10.17226/26507.

No author listed (2019). More than machines. En Nature Machine Intelligence, 7 de Enero de 2019;1(1):1-1. https://doi.org/10.1038/s42256-018-0014-z

Obrist, M. Pavlidis, I. & Gopal, S. (ed) Human-centred intelligent systems [Internet]. Nature. [En imprenta, fecha límite para la aceptación de artículos: 31 March 2023]. Disponible en: https://www.nature.com/collections/cifcfdiiff

OECD (2019) Legal Instruments.OECD/LEGAL/0449, 22/05/2019 https://legalinstruments.oecd.org/en/instruments/OECD-LEGAL-0449

OECD/CAF (2022), Uso estratégico y responsable de la inteligencia artificial en el sector público de América Latina y el Caribe, Estudios de la OCDE sobre Gobernanza Pública, OECD Publishing, Paris, https://doi.org/10.1787/5b189cb4-es.

Schiebinger, L. & Klinge, I. Eds. (2020). Gendered Innovations 2: How Inclusive Analysis Contributes to Research and Innovation (Luxembourg: Publications Office of the European Union, 2020). Foreword by EC Commissioner for Innovation, Research, Culture, Education and Youth, Mariya Gabriel. Stanford University & European Commission, (2020). http://genderedinnovations.stanford.edu/GI%202%20How%20Inclusive%20Analysis%20Contributes%20to%20R&I.pdf

Silvera-Tawil, D.; Bruck, S.; Xiao, Y.; Bradford, D. (2020) Socially-Assistive Robots to Support Learning in Students on the Autism Spectrum: Investigating Educator Perspectives and a Pilot Trial of a Mobile Platform to Remove Barriers to Implementation. Sensors, 2022, 22, 6125. https://doi.org/10.3390/s22166125 https://www.robokind.com/advanced-social-robots

Simon, M., (2019) The Genderless Digital Voice the World Needs Right Now. Wired [Internet]. Science. Wired. March, 11, 2019. https://www.wired.com/story/the-genderless-digital-voice-the-world-needs-right-now/

Stanford University (2020). Gendered Innovations. In Science, Health, Medicine, Engineering, and Environment. Stanford University & European Commission. [Internet]. http://genderedinnovations.stanford.edu/index.html

Tannenbaum C, Ellis RP, Eyssel F, Zou J, Schiebinger L. (2019) Sex and gender analysis improves science and engineering. Nature. noviembre de 2019; 575(7781): pp. 137-146. DOI: https://doi.org/10.1038/s41586-019-1657-6.

UNESCO (2020). Pensar la inteligència artificial responsable: una guia de deliberació. UNESCO, Andorra. 2020 https://www.unesco.ad/2020/09/24/publicacions/pensar-la-inteligencia-artificial-responsable-una-guia-de-deliberacio/

UNESCO (2021) Recomendación sobre la ética de la inteligencia artificial – UNESCO Biblioteca Digital [Internet].SHS/BIO/REC-AIETHICS/2021. https://unesdoc.unesco.org/ark:/48223/pf0000381137_spa

West, M., Kraut, R., Chew Han, E. (2019) I’d blush if I could: closing gender divides in digital skills through education – UNESCO – UNESDOC. Biblioteca Digital. GEN/2019/EQUALS/1 REV.5 [Internet] https://unesdoc.unesco.org/ark:/48223/pf0000367416.page=1

Zou, J., & Schiebinger, L., (2018) AI can be sexist and racist – it’s time to make it fair. Nature. 2018 Jul;559(7714): pp. 324-326. doi: 10.1038/d41586-018-05707-8. PMID: 30018439.

Descargar PDF del Informe. Informe-Tendencias-ODITE-2022.pdf (52851 descargas )