DESENVOLUPAMENT INCLUSIU I DIVERSITAT A LA INTEL·LIGÈNCIA ARTIFICIAL

Investigadora Postdoctoral, Doctora en Sociologia, Equitat, Diversitat i Inclusió al Barcelona Supercomputing Center (BSC). Investigació sobre l’Impacte Social de la Intel·ligència Artificial (IA), Perspectiva de sexe, gènere i diversitat a IA. Membre d’Organització for Women in Science for the Developing World (OWSD), Aliança <A+> per Algorismes Inclusius i Ambaixadora de Women in Data Science Stanford a Espanya.

La Intel·ligència Artificial (IA) és un dels principals reptes de la societat d’avui i del futur. Moltes de les decisions que les persones consideren pròpies ja estan determinades per algorismes, sistemes basats en IA que configuren les nostres democràcies, polítiques socials, sistemes de salut, i fins i tot decisions més quotidianes com l’elecció d’una cançó, una pel·lícula, planificació de viatges, recomanacions d’hotels, assegurances, etc. (Helbing i Pournaras, 2015). Si bé els avenços tecnològics brinden moltes oportunitats, necessitem que aquests sistemes d’informació siguin transparents, fiables i centrats en l’usuari per proporcionar aplicacions útils, en beneficis de totes les persones (Becerik-Gerber, et al. 2022; Obrist, et al. 2023; Koster et al. 2022). També és clau tenir un disseny inclusiu que reflecteixi la realitat social i que sigui representatiu de les diferents característiques de la ciutadania, per resoldre els problemes i les necessitats de tota ella i no únicament d’una part d’aquesta, generant noves desigualtats socials i/o perpetuant les existents.

La IA té incidència en molts sectors, tal com en la producció, el govern, el medi ambient, l’educació, la salut i altres múltiples espais, cosa que requereix avaluacions d’impacte. Amb cada sistema és fonamental examinar el risc de l’ús indegut i les implicacions socials no desitjades, per no reproduir estereotips i no excloure la ciutadania (No author listed, 2019). El gran desafiament és adequar als sistemes d’IA, aplicacions personalitzades i efectives, que considerin les diferents variables socioeconòmiques de cada individu per aconseguir aplicacions d’IA amb precisió, que garanteixin els Drets Humans i la seva orientació a la consecució dels Objectius de Desenvolupament Sostenible (Buslón et al. 2022; UNESCO, 2021).

Hi ha múltiples guies ètiques d’IA al món. El novembre del 2021, els 193 Estats membres de la UNESCO van adoptar el primer acord mundial sobre l’Ètica de la IA com a primer instrument normatiu mundial, no només per protegir sinó per promoure els drets humans i la dignitat, i per generar una base normativa global que permeti construir un sòlid respecte per l’estat de dret al món digital (UNESCO, 2021). Els principis que s’hi estableixen són:

- Proporcionalitat i innocuïtat.

- Seguretat i protecció.

- Equitat i no discriminació.

- Sostenibilitat.

- Dret a la intimitat i protecció de dades.

- Supervisió i decisió humana.

- Transparència i explicabilitat.

- Responsabilitat i rendició de comptes.

- Sensibilització i educació.

- Governança i col·laboració adaptatives i de múltiples parts interessades.

Així mateix, les recomanacions del consell de l’OCDE de 2019 sobre la IA per a polítiques i estratègies públiques a tot el món constaten que és fonamental per a un creixement inclusiu, desenvolupament sostenible i benestar:

- La promoció de valors i equitat centrats en l’ésser humà.

- La transparència i explicabilitat.

- La robustesa, seguretat i protecció de dades dels sistemes.

- El desenvolupament responsable.

- La rendició de comptes.

- La resiliència i

- La mitigació de biaixos nocius

(OECD, 2019; OECD/CAF, 2022).

La IA ha de brindar solucions a la societat lliure de biaixos, que en garanteixi l’ús responsable a la població. Per això les iniciatives i projectes actuals han d’orientar-se a buscar estratègies i formació adequada per identificar els biaixos i desenvolupar sistemes segurs.

La construcció de sistemes amb interacció humana, coneguts com a HBI-Human-Building Interaction, es mostra com una gran eina d’innovació. L’HBI és un camp convergent que representa la complexitat i la necessitat d’una interacció dinàmica entre l’experiència humana i la intel·ligència artificial, dins dels entorns construïts com a visió general per al futur. Les àrees que contribueixen i de les quals es requereix atenció en aquest procés són: els éssers humans (experiències, exercici i benestar); la construcció (disseny, operacions) i les tecnologies (definició, consciència, inferència): els processos que determinaran la presa de decisions; la confiança i la col·laboració en els models d’IA (Becerik-Gerber et al., 2022).

Dins d’aquests models, la perspectiva de sexe, gènere i interseccionalitat és un aspecte fonamental que ha de ser present en aquesta construcció, per garantir la justícia en els sistemes algorítmics per a totes les persones independentment del gènere, raça, cultura, nivell socioeconòmic, edat o nivell educatiu, entre altres variables que ens defineixen com a persones.

La diversitat social i la formació en aquests eixos tindrà un impacte en la determinació de la participació i el disseny, així com en la presa de decisions, desenvolupament i avaluació dels models d’IA. L’èxit a llarg termini de la IA depèn del reconeixement i la implicació de les persones en el seu disseny, operació i ús. Considerar la diversitat en els equips de treball, la participació durant el procés de desenvolupament en els usuaris seleccionats i fins i tot en les referències bibliogràfiques (autories, nacionalitats) o en agregació de les dades i definició dels resultats, ens permetrà assegurar una planificació, cocreació i aplicació adequada. Cal pensar en un model que inclogui un canvi a nivell educatiu, de governança i d’indústria per transformar el desenvolupament científic i tecnològic de la IA.

1. Biaixos en Intel·ligència Artificial

Tenint en compte el potencial transformador que té la IA a la nostra societat, cal dissenyar polítiques que advoquin pel control i la precaució sobre els riscos de biaixos i discriminació per part d’empreses, governs, acadèmia i àmbit tecnològic, involucrats en l’ecosistema de la IA .

Un biaix es defineix com un prejudici a favor o en contra d’una cosa, persona o grup en comparació amb un altre, generalment de manera injusta o negativa. Tot i que hi ha hagut intents de controlar els usos malintencionats i poc ètics de les dades, i d’obrir les “caixes negres” dels algorismes per garantir que no es produeixin danys intencionats i no intencionats, gran part dels sistemes que trobem a la nostra vida quotidiana continuen tenint problemes per resoldre. El biaix inconscient, també conegut com a biaix implícit, es defineix com el conjunt d’actituds i estereotips que influeixen en el judici, la presa de decisions i el comportament, de manera que estan fora del coneixement i/o control conscient (Harvard/ODIB, 2021).

Hi ha múltiples formes de classificar els biaixos en els sistemes de computació. Segons Friedman i Nissenbaum (1996) es poden identificar com a biaixos preexistents, tècnics i emergents. El biaix preexistent té l’origen en els valors, les pràctiques i les actituds de les institucions, per la qual cosa el seu abordatge requereix un canvi cultural, i una revisió de les estructures de participació en el desenvolupament de la tecnologia. El biaix tècnic sorgeix de restriccions tècniques o consideracions en el desenvolupament, que pot ser a les dades, al procés estadístic, o al propi desenvolupament tecnològic. Finalment, el biaix emergent es relaciona amb el context d’ús en què s’aplica i necessita una adaptació a la societat i a l’ambient per no tenir falles en el seu impacte.

Des de la perspectiva de sexe, gènere i interseccionalitat, un dels riscos de la IA és que pugui produir discriminació social i una important pèrdua de confiança per part de la població, si no són identificats o mitigats els biaixos a l’àmbit tecnològic. Així, un sistema basat en IA pot arribar a reproduir resultats sexistes o racistes (Zou & Schiebinger, 2018). Es produeix discriminació quan un algorisme, o les dades d’entrenament històriques a partir de les quals aprèn, contenen errors que porten a tractar diferentment, sense justificació acceptable, persones o grups respecte a la resta de la població. L’impacte de la replicació i perpetuació sistemàtica de biaixos s’amplifica quan sistemes que els incorporen són utilitzats, causant danys a les comunitats subrepresentades, per la qual cosa construir un enteniment comú de la IA per mitigar biaixos i millorar la prestació de serveis socials és un dels reptes més importants.

En l’àmbit de la salut, ignorar el sexe biològic i el gènere, a nivell social, pot conduir a un accés reduït a l’atenció mèdica, a un tractament endarrerit o no adequat i a una pitjor salut de la població. El sexe biològic i el gènere impacten en la recerca bàsica, els estudis preclínics i la salut pública. Això passa, per exemple, quan una màquina concebuda per detectar els càncers de la pell únicament ha estat entrenada únicament amb un tipus de persones (per exemple, homes de pells clares), per la qual cosa no detectarà amb la mateixa fiabilitat els càncers en pells en dones de pell més bruna UNESCO (2020). Estudis recents de la Universitat de MIT i Microsoft Research assenyalen que els algorismes d’aprenentatge automàtic poden discriminar per raça i gènere, cosa que planteja desafiaments que requereixen perspectives ètiques des de la interseccionalitat per manejar models que incorporen prejudicis humans (Buolamwini & Gebru, 2018).

En l’àmbit laboral, la discriminació en sistemes d’IA pot portar a empitjorar la situació de la dona a STEM (Science, Technology, Engineering, Mathematics) i STEAM (Science, Technology, Engineering, Art, Mathematics), excloent-les de les oportunitats laborals més avantatjoses. Això ja ha passat en casos en què dissenys de reclutament automàtic, en revisar els currículums de les persones sol·licitants amb l’objectiu de mecanitzar la recerca dels millors talents científics, es van ensenyar per si mateixos que els candidats masculins eren preferibles (atès que s’esmenten més sovint científics famosos que científiques), penalitzant els currículums que incloïen la paraula “femení” (Dastin, 2018). També a nivell financer els sistemes d’algorismes poden marcar preferència en els que concedeixen crèdits, predeterminats pel gènere, i limitar així la solvència creditícia d’un client.

D’aquesta manera, els biaixos a la IA es poden crear per fenòmens com discriminació passada, desnivellament de classe, fuita d’informació, canvis temporals i sobreajustament, entre altres impactes que afecten la presa de decisions en una política pública, sistema o aplicació amb abast social (Cabrol, et al., 2020). Treballar en la participació humana i amb perspectiva de sexe, gènere i interseccionalitat en les diferents fases de desenvolupament (ex-ante, in itinere i ex post) dels sistemes d’IA amb un enfocament ètic, socioeconòmic i cultural que incorpori pràctiques responsables de disseny, desenvolupament i ús de la tecnologia contribuirà a aconseguir sistemes de IA fiables i representatius de la població. És a dir, a afavorir desenvolupaments que plantegin una revisió en els criteris, enfocament de recerca, pràctiques, preguntes, hipòtesis, mètodes, conformació d’equips, explicabilitat en dades, formació i aplicabilitat en processos.

2. Desenvolupament Inclusiu en IA

Per aconseguir un desenvolupament inclusiu de la IA, cal repensar el disseny global de les ciències i les enginyeries amb el rol de la societat en aquest. Tal com planteja Tannenbaum, (Tannenbaum et al. 2019) cal divisar la responsabilitat de cada sector i establir estratègies a nivell de tres pilars:

- Agències de finançament,

- Universitats i

- Revisions en publicacions científiques.

A més, cal incorporar els governs, la indústria, el sector públic i privat, entre altres esferes fonamentals, en el procés del desenvolupament científic i tecnològic.

És així que les agències nacionals de recerca i el sistema educatiu són responsables de promoure la recerca i la formació d’excel·lència que beneficiï tota la societat. La integració d‟aquesta perspectiva, en el disseny de la recerca, de les tecnologies, potenciarà l‟excel·lència en ciència i podrà desenvolupar una IA que respongui millor a les necessitats socials, aportant millores en la qualitat de vida de les persones, orientada a reduir i eliminar les desigualtats socials (Tannenbaum et al., 2019; Hunt et al., 2022).

D’Ignazio i Klein (2020) plantegen que cal implementar una nova forma de pensar la IA, la ciència de dades i l’ètica de dades, amb una orientació amb perspectiva de gènere, interseccionalitat i feminisme per recolzar el desenvolupament ètic. La diversitat està connectada amb aquest desenvolupament inclusiu que es marca com el mitjà efectiu per millorar l’accés i la qualitat dels sistemes d’IA.

En conseqüència, les dades s’extreuen de les persones i les comunitats, per la qual cosa han de tenir una alineació amb els éssers humans i les seves millors conductes. El que genera una profunda asimetria són les desigualtats entre qui recopila, emmagatzema, analitza i visualitza les dades i els valors que impulsen la societat. És necessari representar en aquests models les dones i grups minoritaris exclosos pel biaix de la IA. També ho hem de potenciar a nivell d’universitats, governs i corporacions per tenir un sector laboral, econòmic i de desenvolupament tecnològic més just i representatiu. Qualsevol sistema que es desenvolupi o implementi ha de seguir una determinació ètica en relació amb el seu impacte social a la població.

Formar la societat i fomentar la cocreació en els processos de desenvolupament d’IA permetrà garantir la protecció de Drets Humans en la regulació i la garantia de llibertats individuals, en establir límits clars en l’ús de la IA. D’aquesta manera, la regulació pot ajudar a prevenir danys cap a les persones i la societat, regular l’ús de tecnologies potencialment perilloses i prevenir biaixos. Comptar amb una participació social inclusiva i diversa ens brindarà una visió més eficaç en el disseny, que evitarà introduir biaixos als models.

D’aquesta manera, el procés atorgarà més transparència a aquests sistemes en l’ús de la IA i podrà definir que els algorismes siguin explicables i auditables. A més, tenir un procés participatiu que promogui mecanismes i eines d’avaluació ex-ante, in itinere i ex post potenciarà la confiança en la tecnologia d’IA, en establir estàndards ètics i tècnics clars durant tot el desenvolupament. Alhora, aquesta definició genera un procés responsable, en què la societat pot establir responsabilitats clares per a les persones desenvolupadores i els usuaris. També genera innovació, ja que la inclusió de diferents perspectives ofereix noves oportunitats i permet visualitzar noves idees i aplicacions i projectar vies d’escalabilitat, creació de nous llocs de treball i sostenibilitat financera.

3. Aspectes ètics i socials en ciències informàtiques

Tenir una visió global de les conseqüències, limitacions i impactes injustos de la informàtica a la societat és fonamental per garantir una IA justa i inclusiva. Analitzar i definir nous estàndards, nou llenguatge i nous sistemes de treball remarca nous mètodes de treballs que s’adeqüen als marcs ètics d’IA, en el desenvolupament i l’aplicació de la tecnologia focalitzada en els humans, en les persones i les seves característiques. és un repte per transformar problemes i evitar noves amenaces.

L’educació de ciències informàtiques posa en manifest que l’especialització d’àrees de coneixement ha fet perdre la visió global i la connexió del saber científic personalitzat amb diferents esferes. Les dades són responsables de molts dels biaixos de la informàtica, ja sigui directament per la recollida o indirectament per l’aplicabilitat (Ko, et al. 2020). Per això, la multidisciplinarietat i la diversitat en els equips de treball és un aspecte potencial quan treballem amb dades i desenvolupament de sistemes d’IA per tenir una perspectiva de les implicacions. D’aquesta manera cal que les persones que treballen en ciències informàtiques rebin formació sobre els aspectes ètics i socials, perspectiva de sexe, gènere i diversitat, durant la seva formació universitària, per aplicar-los als seus sistemes i avançar en un desenvolupament més inclusiu de les ciències .

Actualment, els cursos d’informàtica se centren únicament en la programació tècnica i els enfocaments matemàtics, no aconseguint preparar els estudiants per comprendre com les tecnologies influeixen en els sistemes legals, governs, sistemes econòmics i culturals. La incorporació de l’anàlisi de sexe, gènere, diversitat i interseccionalitat als cursos bàsics d’informàtica pot millorar les habilitats crítiques de professionals a l’àrea de la IA, amb la capacitat de reconèixer les injustícies sistèmiques perpetuades per la tecnologia i preparar millor la força laboral científica per al futur (Ko, et al., 2020).

Fomentar el coneixement en ciències d’informàtica inclusiu i responsable ha esdevingut una de les prioritats a nivell internacional. Les guies ètiques esmentades, com les de la UNESCO (2021) i l’OECD/CAF (2022), igual que s’aplica des de la Unió Europea (Schiebinger & Klinge 2020), estan alineades al voltant de l’objectiu principal de brindar formació i educar a les persones responsables en computació dels desenvolupaments tecnològics al voltant de l’impacte de la IA a la població (Stanford University, 2020). Així, es planteja com a vital que la comunitat de recerca informàtica pugui abordar els desafiaments ètics i socials que sorgeixin amb la IA anticipant els riscos socials des del principi. I per això cal disposar de formació amb una perspectiva que inclogui dimensions socials, polítiques i econòmiques en les primeres etapes de recerca per reduir danys potencials (Grosz et al., 2019; Horton, et al. 2022; National Academies of Sciences, Engineering , and Medicine, 2022).

El projecte Gendered Innovations de Stanford (Stanford University, 2020) és el marc de referència mundial sobre la perspectiva de sexe, gènere i interseccionalitat en ciència que impulsa el valor en la investigació i l’enginyeria, en la societat i els negocis. Aquest destaca la rellevància del projecte “Embedded EthiCS” (Grosz, et al., 2019; Harvard University, 2019) com un dels principals exemples als Estats Units i al món a integrar el raonament ètic en els cursos bàsics de ciències de la computació. És un model que apunta a una computació responsable i inclusiva, que incorpora una anàlisi sociocultural que potencia habilitats de les humanitats i les ciències socials en la formació tècnica.

Actualment hi ha diverses iniciatives al món, tal com indica Gendered Innovations (a Stanford, Mozilla, University of Buffalo, Geòrgia Tech, MIT, Columbia University, etc.), que integren l’ètica a les classes d’informàtica i als plans d’estudi . A nivell local, esmentem el treball que es fa al Barcelona el Supercomputing Center des de l’any 2021, amb el disseny de cursos sobre l’anàlisi de sexe, gènere i interseccionalitat en ciència, amb diapositives, tasques, notes i exemples d’eines de dades , accessibles per a estudiants de doctorat en ciències de la computació, bioinformàtica, ciències de la terra i informàtica aplicada (Barcelona Supercomputing Center, 2023). Aquest mòdul fa referències a biaixos que s’han trobat a IA amb característiques de gènere, edat, nivell socioeconòmic, etc., analitzant guies ètiques de referència, per constatar exemples d’aplicació en medicina personalitzada i altres esferes de treball. L’objectiu és que l’alumnat de doctorat pugui aplicar aquesta perspectiva en el procés científic: des de la selecció de referències de treball, la definició d’equips diversos i inclusius, la definició de les vostres preguntes de recerca, hipòtesis, definició de dades, anàlisi, participació social d’usuaris al desenvolupament, fins a la difusió en conferències, atenció a referències bibliogràfiques, etc.

Aquest procés i els diferents mètodes de formació busquen fomentar un canvi crític en les ciències informàtiques, el raonament ètic i social com una habilitat essencial per a les persones que treballen en els sistemes d’IA. Els cursos que es dissenyen tenen com a objectiu aplicar aquests conceptes a les universitats, empreses, etc. serà canviar el pensament i la definició de la tecnologia mitjançant una visió més centrada en la construcció de sistemes amb interacció humana.

4. Bones pràctiques de desenvolupament inclusiu a la IA

Els estudis de les Nacions Unides (West et al., 2019) han alertat del perill de reproduir estereotips de gènere a les tecnologies. Les qüestions de gènere aborden debats amb més força a mesura que la IA té més capacitat d’incidència a la societat i capacitat de comunicació similar a les humanes. Realitzar veus femenines com a assistents virtuals, reafirmant la visió de dones com a ajudants, o robots que tenen formes masculines quan són per mostrar exemples d’eficàcia i autoritat, són accions que reforcen els estereotips de gènere i s’assenyalen com alguns dels riscos en el desenvolupament tecnològic.

A la Figura 1 trobem una alternativa a les veus d’assistents virtuals que coneixem com a Alexa d’Amazon, Siri d’Apple, o l’assistent de Google amb veu que respon femenina. Q és un disseny realitzat per un equip de recerca a IA que té una veu de gènere neutra (https://www.genderlessvoice.com/). Un dels punts claus per a aquest equip de treball era contribuir a una conversa global sobre els biaixos de gènere, tecnologia i aspectes ètics. En paraules de Carpenter, J buscaven: “…com ser inclusius per a les persones que s’identifiquen de moltes maneres diferents” (Mortada, 2019; Simon, 2019). La veu Q va ser desenvolupada com a part de les iniciatives de l’Orgull Copenhaguen (Copenhagen Pride, 2020) i altres líders de la iniciativa EqualAI (EqualAI, 2023), seguint un esquema de treball col·laboratiu, en un equip de recerca, juntament amb dissenyadors de so i lingüistes. Durant aquest treball, van aconseguir dissenyar un nou sistema d’IA que trenca amb esquemes establerts per les grans empreses privades que ofereixen serveis d’assistència virtual.

És clau destacar que per al procés de disseny i desenvolupament del sistema d’IA es van enregistrar i van participar dotzenes de persones amb diferents perfils, que s’identifiquen en diferents gèneres (dones, homes, transgènere i no binaris), per la qual cosa el seu treball va ser un clar exemple de sistemes d’IA inclusius i diversos que van aplicar un sistema de cocreació durant tot el procés de treball, la fase inicial, el procés de treball i les proves de tancament. La meta final es va complir, obtenint una veu de gènere neutre, ara el segon pas serà que aconseguim escoltar Q com a opció de veu a les veus d’assistència virtual al món (Mortada, 2019). [Figura 1].

Figura 1. Meet Q – Assistent de veu de gènere neutre

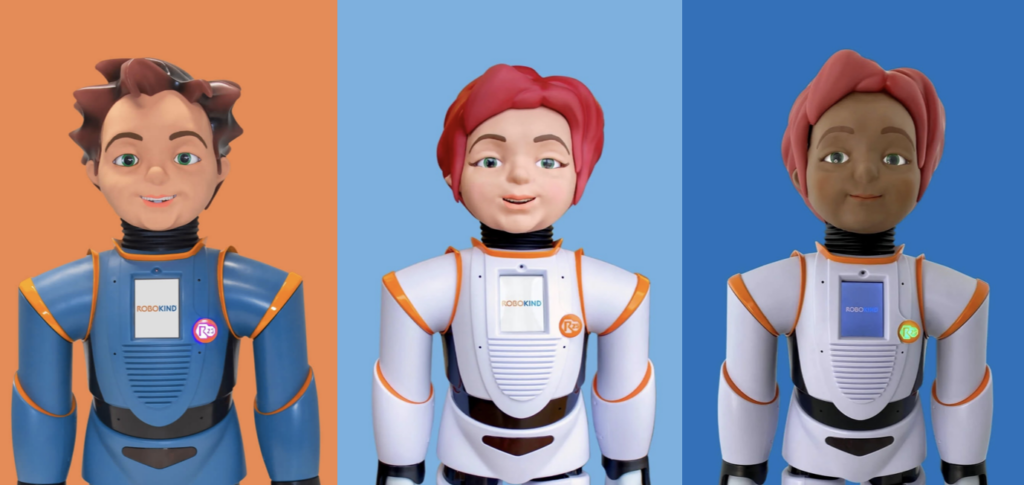

A la Figura 2 trobem Milo, Jemi, Veda, tres robots que tenen la intersecció entre variables com a gènere, discapacitat i origen ètnic. Aquest robot va ser dissenyat per Robokind (Schiebinger et al., 2020; Silvera-Tawil, et al. 2020) per al tractament de l’espectre autista (ASD). En aquest cas, s’ofereixen diferents opcions considerant la diversitat de pacients i tenint en compte que la identificació és positiva per a la interacció. Els models que aplica Robokind semblants a nenes, nens diferents i inclusius donen eines educatives útils i mostren que podem crear robots personalitzats que prioritzen la igualtat de gènere i eviten estereotips humans.

Figura 2. Milo, Jemi, Veda. Robot social per al tractament de l’espectre autista (ASD)

En aquest sentit, l’educació sobre aspectes ètics i socials en la formació en ciències de la computació, la participació de les persones en el disseny de la IA, així com la perspectiva de sexe, gènere i interseccionalitat durant tot el procés de disseny, desenvolupament i aplicació de la IA, potenciaran un canvi important a la tecnologia. L’objectiu serà tenir una perspectiva més àmplia en què les persones puguin manifestar les seves necessitats i experiències i que aquests coneixements siguin aplicats al disseny i sistemes d’IA per complir amb els objectius i valors prioritaris exposats.

Transformar l’esquema de disseny, la interacció amb les persones usuàries i la formació planteja un gir en la responsabilitat, l’accessibilitat, la confiança i la qualitat dels sistemes d’IA. Tots aquests aspectes garantiran que tinguem models més justos, ètics, accessibles i de gran qualitat que transformin positivament la societat futura.

Bibliografia i enllaços relacionats

Barcelona Supercomputing Center (2023) PhD Programmes and Graduate Committee [Internet]. BSC-CNS. https://www.bsc.es/education/predoctoral-phd/phd-programmes

Becerik-Gerber, B., Lucas, G., Aryal, A., Awada. M., Bergés, M., Billington, S., Boric-Lubecke, O., Ghahramani, A., Heydarian, A., Höelscher, C., Jazizadeh, F., Khan, A., Langevin, J., Liu, R., Marks, F., Mauriello, M.L, Murnane, E., Noh, H., Pritoni, M., Roll, S., Schaumann, D., Seyedrezaei, M., Taylor, J.E., Zhao, J., Zhu, R.. (2022). The field of human building interaction for convergent research and innovation for intelligent built environments. Sci Rep. 2022 Dec 21;12(1):22092. doi: 10.1038/s41598-022-25047-y. PMID: 36543830; PMCID: PMC9769481.

Buolamwini, J. & ; Gebru, T.. (2018). Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification. In Proceedings of the 1st Conference on Fairness, Accountability and Transparency (2018) in Proceedings of Machine Learning Research, PMLR 81: pp. 77-91 https://proceedings.mlr.press/v81/buolamwini18a.html.

Buslón N, Racionero-Plaza S, Cortés A. (2022) Chapter 2 – Sex and gender inequality in precision medicine: Socioeconomic determinants of health. En: Cirillo D, Catuara-Solarz S, Guney E, editores. Sex and Gender Bias in Technology and Artificial Intelligence [Internet]. Academic Press; 2022 pp. 35-54.: https://www.sciencedirect.com/science/article/pii/B9780128213926000054

Cabrol, M., González A.N., Pombo, C., Sánchez, A.R., (2020) fAIr LAC: Adopción ética y responsable de la inteligencia artificial en América Latina y el Caribe [Internet]. Inter-American Development Bank; 2020 Ene. DOI: http://dx.doi.org/10.18235/0002169

Copenhagen Pride. (2020). Copenhagen Pride HeartCore – The Official Copenhagen Pride Magazine. [Internet]. https://www.copenhagenpride.dk/en/magazine/

Dastin, J. (2018) Amazon scraps secret AI recruiting tool that showed bias against women. Reuters [Internet]. 10 de octubre de 2018 https://www.reuters.com/article/us-amazon-com-jobs-automation-insight-idUSKCN1MK08G

D’Ignazio, C. & Klein, L.F. (2020) Data Feminism [Internet]. The MIT Press. 10/03/2020. http://mitpress.mit.edu/9780262044004/data-feminism/

EqualAI (2023). Leading the movement for innovative, responsible, and inclusive artificial intelligence.[Internet] https://www.equalai.org/

Friedman B, and Nissenbaum H. (1996). Bias in computer systems. ACM Trans Inf S yst. 1 de julio de 1996;14(3):330-47. 1 de julio de 1996;14(3): pp. 330-347.Helbing D, Pournaras E. (2015) Society: Build digital democracy. Nature. 5 de noviembre de 2015; 527(7576): pp. 33-34. doi: 10.1038/527033a.

Grosz, B.J., Grant, D.G., Vredenburgh, K., Behrends, J., Hu, L., Simmons, A., et al. (2019) Embedded EthiCS: integrating ethics across CS education. Commun ACM. 24 de julio de 2019;62(8): pp.54-61.

Harvard/ODIB (2021) ODIB Glossary: Equity, diversity, access, inclusion & belonging. Foundational Concepts & Affirming Language https://edib.harvard.edu/files/dib/files/oedib_foundational_concepts_and_affirming_language_12.7.21.pdf?m=1638887160 https://edib.harvard.edu/dib-glossary

Harvard University (2019). Embedded EthiCS @Harvard: Bringing ethical reasoning into the computer science curriculum. [Internet: Web y vídeo]. Harvard University. Team: Grosz, B., Simmons, A., Behrends, J., Chong, S., Mickens, J., Vadhan, S., Wattenberg, M. https://embeddedethics.seas.harvard.edu/home

Horton D, McIlraith SA, Wang N, Majedi M, McClure E, Wald B. (2022) Embedding Ethics in Computer Science Courses: Does it Work? En: Proceedings of the 53rd ACM Technical Symposium on Computer Science Education – Volume 1, 2022 [Internet]. New York, NY, USA: Association for Computing Machinery, p. 481-7. (SIGCSE 2022; vol. 1). https://doi.org/10.1145/3478431.3499407

Hunt L, Nielsen MW, Schiebinger L. (2022) A framework for sex, gender, and diversity analysis in research. Science. 30 de septiembre de 2022;377(6614):1492-5.

Ko, A.J., Oleson, A., Ryan, N., Register, Y., Xie, B., Tari, M., et al. (2020) It is time for more critical CS education. Commun ACM. 22 de octubre de 2020;63(11):31-3.

Koster R, Balaguer J, Tacchetti A, Weinstein A, Zhu T, Hauser O, et al. (2022) Human-centred mechanism design with Democratic AI. Nat Hum Behav. 6 de octubre de 2022; 6(10):1398-407.

Mortada, D., & Meet, Q., (2019). The Gender-Neutral Voice Assistant. NPR [Internet]. 21 de marzo de 2019 https://www.npr.org/2019/03/21/705395100/meet-q-the-gender-neutral-voice-assistant

National Academies of Sciences, Engineering, and Medicine. (2022). Fostering Responsible Computing Research: Foundations and Practices. Washington, DC: The National Academies Press. https://doi.org/10.17226/26507.

No author listed (2019). More than machines. En Nature Machine Intelligence, 7 de Enero de 2019;1(1):1-1. https://doi.org/10.1038/s42256-018-0014-z

Obrist, M. Pavlidis, I. & Gopal, S. (ed) Human-centred intelligent systems [Internet]. Nature. [En imprenta, fecha límite para la aceptación de artículos: 31 March 2023]. Disponible en: https://www.nature.com/collections/cifcfdiiff

OECD (2019) Legal Instruments.OECD/LEGAL/0449, 22/05/2019 https://legalinstruments.oecd.org/en/instruments/OECD-LEGAL-0449

OECD/CAF (2022), Uso estratégico y responsable de la inteligencia artificial en el sector público de América Latina y el Caribe, Estudios de la OCDE sobre Gobernanza Pública, OECD Publishing, Paris, https://doi.org/10.1787/5b189cb4-es.

Schiebinger, L. & Klinge, I. Eds. (2020). Gendered Innovations 2: How Inclusive Analysis Contributes to Research and Innovation (Luxembourg: Publications Office of the European Union, 2020). Foreword by EC Commissioner for Innovation, Research, Culture, Education and Youth, Mariya Gabriel. Stanford University & European Commission, (2020). http://genderedinnovations.stanford.edu/GI%202%20How%20Inclusive%20Analysis%20Contributes%20to%20R&I.pdf

Silvera-Tawil, D.; Bruck, S.; Xiao, Y.; Bradford, D. (2020) Socially-Assistive Robots to Support Learning in Students on the Autism Spectrum: Investigating Educator Perspectives and a Pilot Trial of a Mobile Platform to Remove Barriers to Implementation. Sensors, 2022, 22, 6125. https://doi.org/10.3390/s22166125 https://www.robokind.com/advanced-social-robots

Simon, M., (2019) The Genderless Digital Voice the World Needs Right Now. Wired [Internet]. Science. Wired. March, 11, 2019. https://www.wired.com/story/the-genderless-digital-voice-the-world-needs-right-now/

Stanford University (2020). Gendered Innovations. In Science, Health, Medicine, Engineering, and Environment. Stanford University & European Commission. [Internet]. http://genderedinnovations.stanford.edu/index.html

Tannenbaum C, Ellis RP, Eyssel F, Zou J, Schiebinger L. (2019) Sex and gender analysis improves science and engineering. Nature. noviembre de 2019; 575(7781): pp. 137-146. DOI: https://doi.org/10.1038/s41586-019-1657-6.

UNESCO (2020). Pensar la inteligència artificial responsable: una guia de deliberació. UNESCO, Andorra. 2020 https://www.unesco.ad/2020/09/24/publicacions/pensar-la-inteligencia-artificial-responsable-una-guia-de-deliberacio/

UNESCO (2021) Recomendación sobre la ética de la inteligencia artificial – UNESCO Biblioteca Digital [Internet].SHS/BIO/REC-AIETHICS/2021. https://unesdoc.unesco.org/ark:/48223/pf0000381137_spa

West, M., Kraut, R., Chew Han, E. (2019) I’d blush if I could: closing gender divides in digital skills through education – UNESCO – UNESDOC. Biblioteca Digital. GEN/2019/EQUALS/1 REV.5 [Internet] https://unesdoc.unesco.org/ark:/48223/pf0000367416.page=1

Zou, J., & Schiebinger, L., (2018) AI can be sexist and racist – it’s time to make it fair. Nature. 2018 Jul;559(7714): pp. 324-326. doi: 10.1038/d41586-018-05707-8. PMID: 30018439.

Descarregar PDF de l’Informe. Informe-Tendencias-ODITE-2022.pdf (56157 downloads )